La inteligencia artificial ha dotado de nuevas armas a delincuentes y estafadores, quienes ahora están aprovechando esta tecnología de vanguardia para elaborar engaños cada vez más verosímiles y difíciles de descubrir (si aún no lo hizo, puede leer sobre eso aquí). Desde deepfakes de celebridades y estafas inmobiliarias con imágenes generadas por IA, hasta la clonación de voces de seres queridos, el panorama es sin dudas alarmante, exponiendo a las personas a una situación de mayor vulnerabilidad.

Si bien es cierto que la IA habilita a personas sin una experiencia técnica mínima para preparar y ejecutar fraudes complejos, también es verdad que el conocimiento bien aplicado se convierte en la mejor defensa, brindando una clara ventaja ante aquellos que se encuentran desnudos de información frente a un ataque de este tipo. Comprender cómo funcionan estas estafas es el primer paso para evitar caer en ellas. Además, estar informado sobre las últimas tácticas y herramientas utilizadas por los estafadores puede ayudar a identificar señales de alerta con la anticipación suficiente como para implementar medidas efectivas a tiempo. La educación y la capacitación continua son esenciales para protegerse en un entorno digital de una hostilidad cada vez más sofisticada.

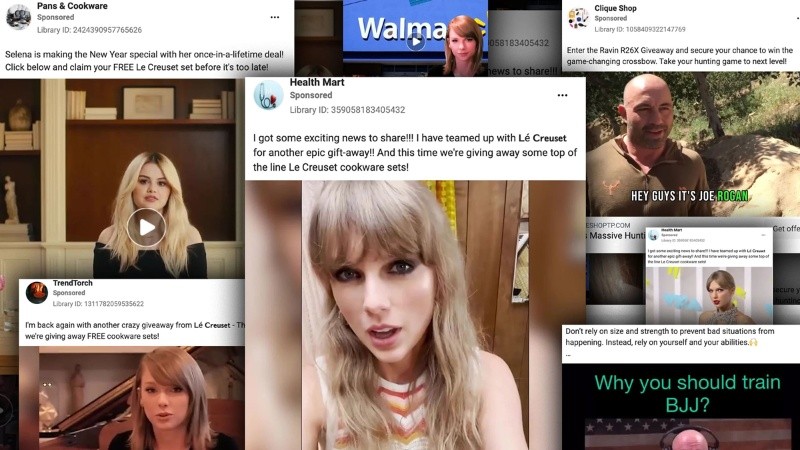

La proliferación de los deepfakes ha hecho que la detección de estas manipulaciones digitales sea una necesidad cada vez más urgente. No solo pueden ser utilizados para desinformar o influir en la opinión pública desde la difusión de fake news, también puede causar verdaderos estragos en la reputación de una persona a partir de la generación de contenido falso. En muchos casos, y especialmente en las redes sociales, los ciberdelincuentes suelen recurrir a los deepfakes para intentar engañar a los fanáticos de alguna estrella, haciéndoles creer que están viendo contenido auténtico cuando en realidad se trata de una simulación.

Una de las principales medidas de protección para evitar caer en esta farsa es la cautela. Por regla general, hay que desconfiar de las ofertas demasiado buenas para ser verdad, especialmente si provienen de celebridades. En primer lugar, debemos comprobar la autenticidad de la cuenta que publica el video en cuestión buscando el tilde azul de verificación. También es recomendable realizar una búsqueda rápida en la web, consultando fuentes confiables que alerten sobre posibles fraudes en curso o, en todo caso, que confirmen la información. Si una estrella del pop realmente regala vajilla francesa o un multimillonario ofrece criptomonedas gratuitamente, es probable que la noticia esté publicada en medios de comunicación reconocidos.

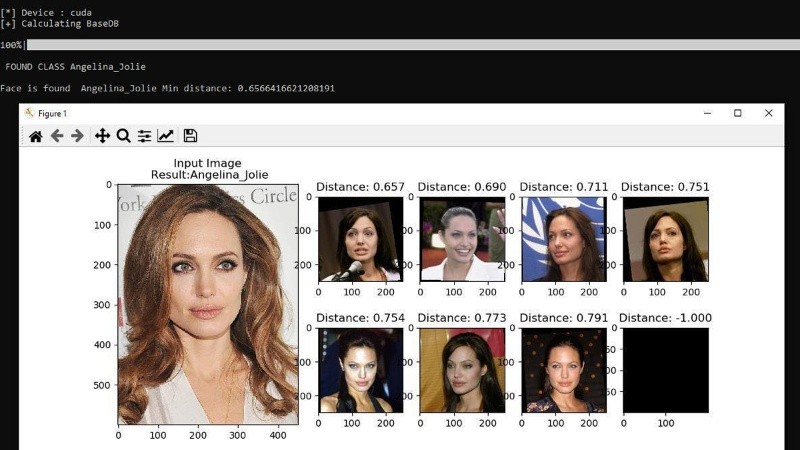

Los cheapfakes, vídeos manipulados mediante medios convencionales de edición de audio y video, pueden ser distinguidos por el ojo humano con cierta facilidad. Sin embargo, a medida que los deepfakes realistas basados en inteligencia artificial se vuelven más convincentes, se requiere asistencia tecnológica para identificarlos.

Para esto, se puede recurrir a alguna de las herramientas gratuitas disponibles en la red para la detección de deepfakes, como Deepware, que puede escanear vídeos de plataformas como YouTube, Facebook y X (antes Twitter) en busca de manipulaciones faciales realizadas por IA, aunque también permite subir vídeos de hasta 10 minutos de duración para su análisis. El sistema busca señales de manipulación, especialmente en rostros humanos, y proporciona un informe detallado de sus hallazgos, incluído un puntaje que indica la probabilidad de que el video sea un deepfake.

Actualmente, las estafas de clonación de voz se han convertido en unas de las amenazas que más preocupación generan en el ámbito de la ciberseguridad, y si bien no existe una estadística global definitiva, numerosos informes indican un aumento sustancial en este tipo de ataques. Según una encuesta realizada por McAfee, uno de cada 10 adultos en el mundo ha sufrido una estafa de voz mediante inteligencia artificial, y el 77% de las víctimas de este tipo de fraude sufrieron pérdidas económicas. El mismo estudio revela un dato aún más inquietante: el 70% de los encuestados admitió no estar seguro de poder distinguir entre una voz real y una clonada.

Para protegerse de las estafas de deepfakes de voz, es primordial mantenerse cauteloso con las solicitudes urgentes: si un familiar o un amigo nos llama desde un número que no tenemos agendado y nos pide inesperadamente una suma de dinero, debemos resistir el impulso natural de actuar de inmediato y tomarnos unos minutos para analizar la situación. Lo ideal es contactar a la otra persona a través de otro medio o número conocido antes de realizar cualquier acción.

Para esto, es útil tener una palabra de seguridad acordada previamente, o hacer preguntas específicas o personales que solo la persona real podría responder con facilidad, lo que puede desenmascarar a los estafadores. Si al recibir una llamada de alguien que se hace pasar por nuestro hijo le preguntamos “¿cuál es la comida favorita de la abuela?”, probablemente se haga un silencio del otro lado. Esta pausa crítica puede ser la diferencia entre ser víctima de un fraude o detectarlo a tiempo. También hay que estar atento a otras señales de advertencia, como inconsistencias en el discurso, cambios sutiles en el tono de voz o el uso de frases que normalmente la persona no utilizaría.

Las identidades falsas generadas mediante IA en redes sociales y aplicaciones de citas se han convertido en un fenómeno alarmante, principalmente por su explotación en fraudes tanto emocionales como financieros. Estas suplantaciones han evolucionado de simples engaños a elaboradas estrategias de manipulación, que en muchos casos terminan en grandes pérdidas económicas para las víctimas. Para evitar caer en estas trampas, es importante mantener un nivel saludable de escepticismo al momento de interactuar con personas desconocidas.

Primero, es imprescindible verificar si la persona es realmente quien dice ser. Eso requiere un análisis en profundidad de sus redes sociales, prestando especial atención a las fechas de creación de las cuentas y de publicación de contenido. Los perfiles falsos suelen mostrar, por un lado, actividad reciente, y por el otro, escasa interacción genuina con amigos o familiares. Además, sus fotos y posteos tienden a ser limitadas y restringidas a un periodo de tiempo inusualmente corto. Esta falta de contenido histórico en sus redes es uno de los principales indicadores de que estamos frente a una identidad ficticia. No hace falta aclarar que nunca hay que enviarle dinero o revelar información confidencial a alguien que no conozcamos personalmente.

La última novedad en la esfera de los fraudes es la de las estafas inmobiliarias con imágenes generadas por IA. Este fenómeno emergente representa una nueva y sofisticada amenaza en el mercado de bienes raíces, aprovechando la tecnología generativa para crear imágenes falsas pero sumamente convincentes de propiedades, engañando a potenciales compradores o arrendatarios. Estas imágenes se publican en plataformas de bienes raíces o redes sociales, acompañadas de descripciones atractivas y precios aparentemente competitivos. Esta modalidad de fraude se aprovecha de aquellos que, por la distancia, se ven imposibilitados de realizar visitas presenciales, presionándolos para realizar depósitos para “asegurar” propiedades que son radicalmente diferentes a lo mostrado, o directamente no existen.

“Es una situación que aún no se ha dado acá porque todavía manejamos mucho lo real contra lo virtual, al menos en el mercado inmobiliario tradicional”, señala a Rosario3 José Ellena, referente de la Cámara Inmobiliaria de Rosario (CIR). “Sí hay tantos casos que suelen pasar, sobre todo en época estival, en distintos lugares de acá donde se alquilan casas de veraneo, llámese Funes o Roldan, en las cuales no mediante la inteligencia artificial, sino mediante engaños, te alquilan cosas que no se alquilan. O cuando vas y la ves no condice para nada la realidad con lo que te vendieron en imágenes”, detalla Ellena.

Es de esperarse que una modalidad de estafa que se está difundiendo tan rápido en España sea eventualmente replicada en otros países, como Argentina. Para combatir esta nueva amenaza, Ellena sugiere una serie de medidas preventivas, entre ellas, contratar un corredor matriculado. “Un corredor matriculado, independientemente de ser un profesional y de tener el respaldo de ser un idóneo en la materia, tiene la obligación de tener a la vista y de exhibir toda la documentación pertinente a la propiedad que ofrece”, explica el referente de la CIR.

“Asimismo, por ser un corredor matriculado al Colegio de Corredores, si no cumpliera con alguna de las contraprestaciones ofrecidas, se expone a una denuncia en el Tribunal de Ética del Colegio y a tener las sanciones pertinentes”, agrega el especialista en mercado inmobiliario. ”Si bien este tipo de situaciones aún no se han dado, podrían llegar a ocurrir en el futuro. Por eso, recomendamos siempre contratar un corredor inmobiliario matriculado para garantizar la seguridad y transparencia de la operación”, subraya Ellena.

En este mecanismo de fraude, los estafadores no solo utilizan herramientas de IA para generar imágenes realistas de propiedades inexistentes, sino también para mejorar considerablemente el aspecto de propiedades en mal estado. Entre las inequívocas señales de alerta de que nos encontramos frente a un engaño podemos destacar fotografías demasiado perfectas o idealizadas, inconsistencias en los detalles arquitectónicos y la falta de imperfecciones naturales en la composición de las imágenes. Los embaucadores también evitarán la posibilidad de realizar visitas presenciales a la propiedad apelando a diferentes excusas, al mismo tiempo que presionarán para realizar pagos o depósitos cuanto antes.

La batalla contra el fraude en la era de la inteligencia artificial supone una dedicación constante, ya que a medida que la tecnología evoluciona, también lo hacen las tácticas de los estafadores y ciberdelincuentes. Evitar convertirse en víctima requiere de un esfuerzo por mantenerse actualizado en las últimas estrategias utilizadas por estos maestros del engaño, el uso de herramientas tecnológicas de verificación y una buena dosis de escepticismo y cautela. En última instancia, la clave para permanecer a la vanguardia en este panorama cambiante y dinámico de amenazas digitales es la adaptabilidad.