Distintos especialistas en Inteligencia Artificial (IA) vienen sosteniendo desde hace tiempo discusiones sobre los riesgos y posibles consecuencias del desarrollo apresurado de este tipo de tecnología, que desde el lanzamiento del bot conversacional ChatGPT pasó a ser el principal interés de muchas compañías del sector a nivel internacional.

Una de las personalidades autorizadas en la materia que se expresó al respecto fue el jefe de IA del Pentágono, Craig Martell, quien aseguró estar "asustado" frente a las posibilidades que se abren a raíz de desarrollos como los que se están viendo actualmente.

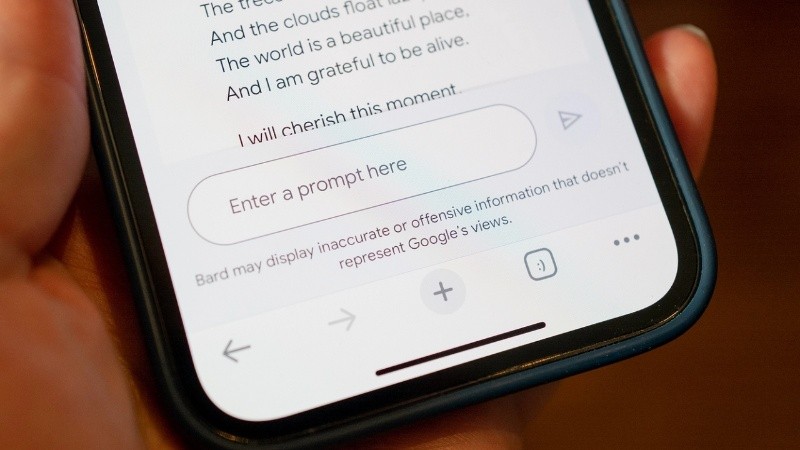

ChatGPT, de la empresa OpenAI, marcó un antes y un después en el acceso libre a sistemas que funcionan con inteligencia artificial, dándole la posibilidad a millones de personas de generar, en cuestión de segundos, textos en lenguaje natural sobre prácticamente cualquier tema.

Sin embargo, esa capacidad que tiene para procesar información y devolver textos originales también conlleva el riesgo de que los resultados contengan información errónea e incluso sesgada.

Es por esto que Martell, director de Inteligencia Digital y Artificial del Departamento de Defensa de Estados Unidos, hizo una advertencia: "No nos vendan solo la generación, trabajen también en la detección", en referencia a los errores y a la información falsa que pueden contener los textos generados con IA.

El experto hizo referencia a, por ejemplo, la simulación de avatares o la clonación de voz, o las imágenes generadas por IA que tienen una calidad similar a la fotográfica. "Esta información desencadena una respuesta psicológica que lleva a pensar que esto tiene autoridad", apuntó durante la conferencia cibernética TechNet organizada por la Asociación de Electrónica y Comunicaciones de las Fuerzas Armadas, según consignó el medio Breaking Defense.

Martell aseguró que se encuentra "muerto de miedo" por el uso que puedan darle los usuarios a los recursos de la IA, al tiempo que se refirió a las aplicaciones de este tipo como "una herramienta perfecta para la desinformación" y consideró que "estamos atrasados" en la lucha contra este problemática.

"Si le preguntás a ChatGPT: «¿Puedo confiar en vos?», su respuesta data de un largo «no». No bromeo. Dice que es una herramienta que va a darte una respuesta, pero que te corresponde a vos ir a verificarlo por vos mismo", destacó el experto, que luego concluyó: "Mi temor sobre usar esta tecnología, a diferencia de los temores de que nuestros adversarios la usen, es que confiemos demasiado en ella sin que los proveedores del servicio construyan las garantías adecuadas y la capacidad para que nosotros lo validemos".